Code: https://github.com/DengPingFan/PraNet

Motivation

息肉分割存在两个主要问题:

- 相同类型的息肉具有不同的大小、颜色和质地

- 息肉与其周围粘膜之间的边界不清晰

本文提出一种新颖的深度神经网络,称为并行反向注意力网络(PraNet)。模仿临床医生,首先粗略定位息肉,然后根据局部特征准确提取其Mask。此方法具有三个优点:

- 更好的学习能力

- 增强的泛化能力

- 更高的训练效率

本文贡献:

- 提出了实时息肉分割框架PraNet

- 介绍了针对息肉分割的评价指标,提供SOTA模型

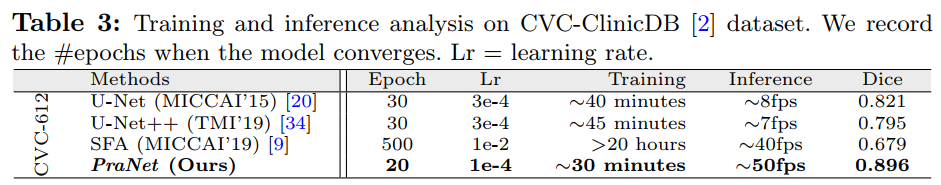

- 在五个数据集上都优于现有模型,并且能够实时推断、训练时间减少

Methods

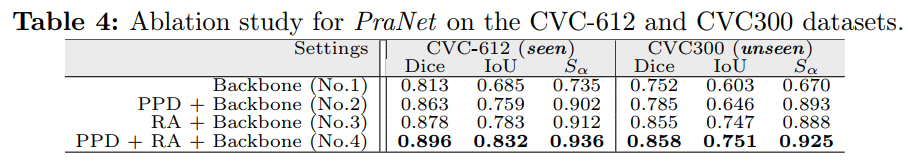

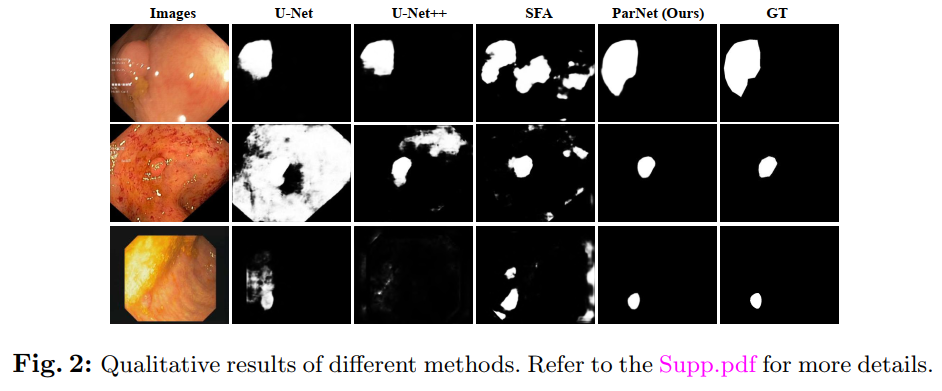

Feature Aggregating via Parallel Partial Decoder

比较流行的医学影像分割方法主要依靠U-Net或U-Net的变体,这些方法聚合多级特征,但与高级特征相比,低级特征有较大的空间分辨率而需要更多计算资源,对性能的贡献较小。

针对此问题,提出Parallel Partial Decoder结构。

- 通过Res2Net-based backbone提取5级特征\(\{f_i, i=1,...,5\}\)

- 将特征分为低级特征\(\{f_i, i=1,2\}\)和高级特征\(\{f_i, i=3,4,5\}\)

- 引入partial decoder \(p_d(\cdot)\),用于并行聚合高级特征。通过\(PD=p_d(f_3, f_4, f_5)\)计算可以得到全局图\(S_g\)

Reverse Attention Module

临床阶段,医生首先粗略定位息肉区域,然后仔细找出息肉的精确位置。前文提到的全局图\(S_g\)产生自最深层网络,只能获得息肉相对粗糙的位置,而没有结构信息。

提出一种基于擦除方式的策略逐步探索可判别的息肉区域,自适应的并行学习高级特征中的Reverse Attention。

通过将高级特征\(\{f_i, i=3,4,5\}\)逐像素与Reverse Attention权重\(A_i\)相乘得到Reverse Attention特征。

\[R_i=f_i \odot A_i\]

\(A_i\)主要用于salient object detection,可以通过下面公式计算得到

\[A_i=\ominus(\sigma(P(S_{i+1})))\]

其中,\(P(\cdot)\)为上采样操作,\(\sigma(\cdot)\)为Sigmoid函数,\(\ominus(\cdot)\)为从矩阵E中减去输入的逆运算。

Learning Process and Implementation Details

\[L=L_{IoU}^{w}+L_{BCE}^{w}\]

对IoU损失和BCE损失分别加权,有助于检测目标。

另外对三个side-outputs\((S_3, S_4,S_5)\)进行Deep Supervision。

\[\mathcal{L}_{\text {total}}=\mathcal{L}\left(G, S_{g}^{u p}\right)+\sum_{i=3}^{i=5} \mathcal{L}\left(G, S_{i}^{u p}\right)\]

Experiments

Datasets

- ETIS

- CVC-ClinicDB/CVC-612

- CVC-ColonDB

- EndoScene

- Kvasir

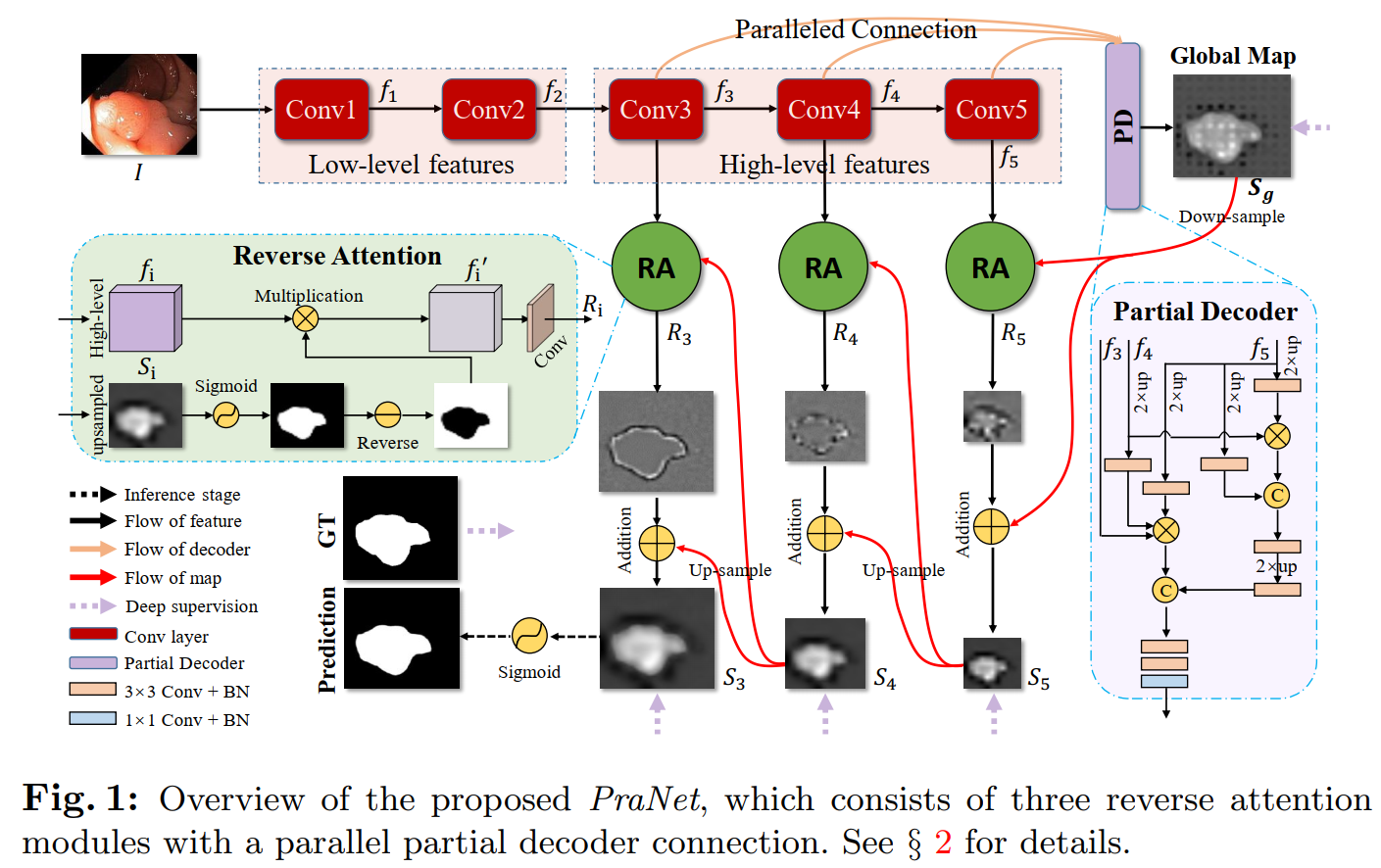

对比模型:

- U-Net

- U-Net++

- ResUNet-mod

- ResUNet++

- SFA

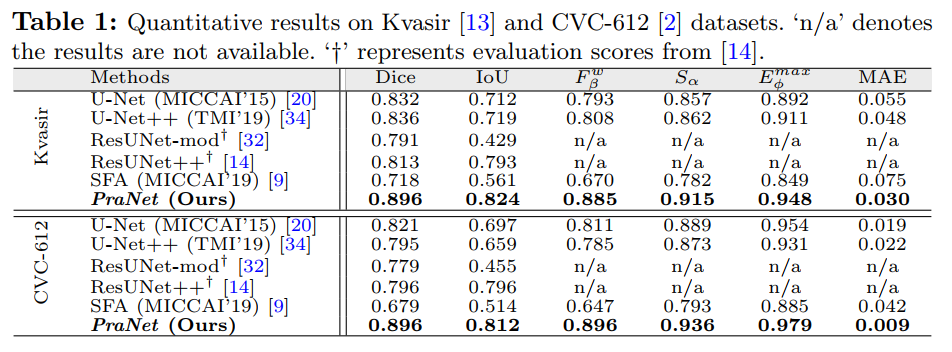

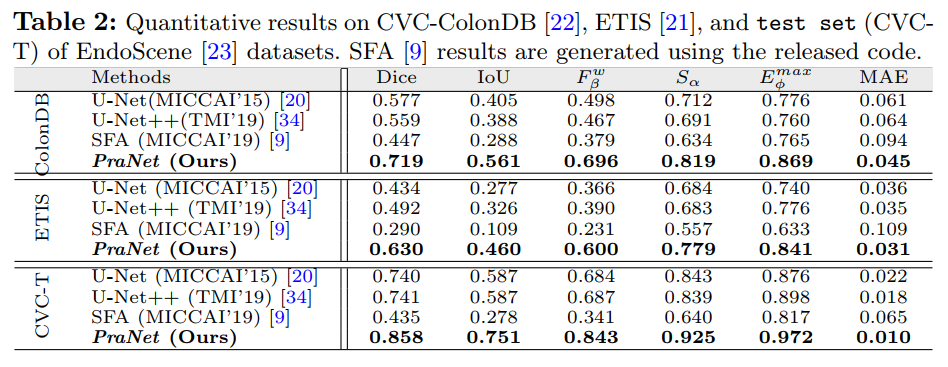

Results