Motivation

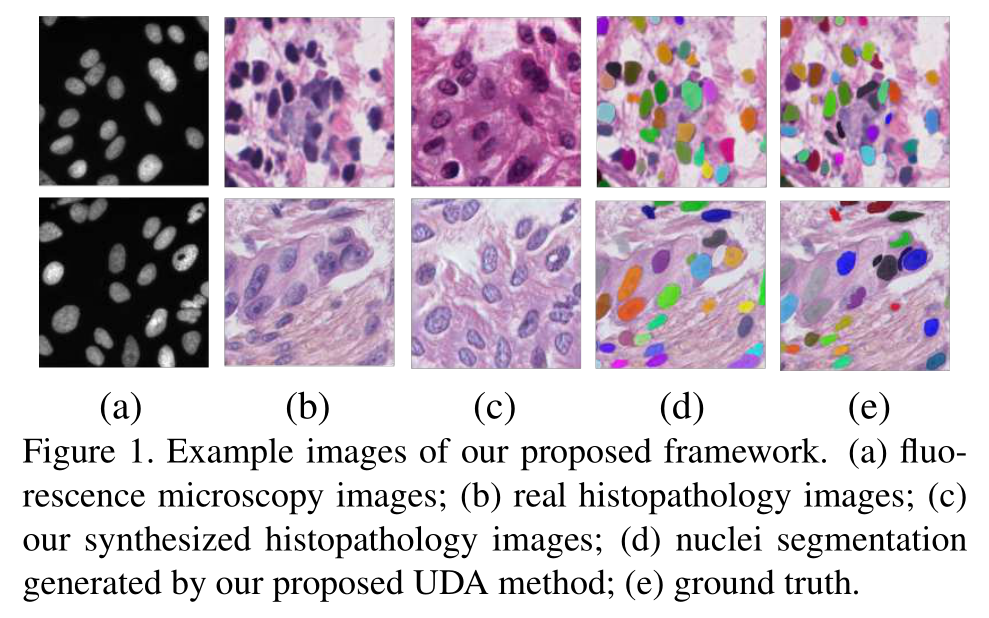

基于无监督域自适应的数字病理学核实例分割,能够减轻标注的工作量和跨数据集的域迁移负担。

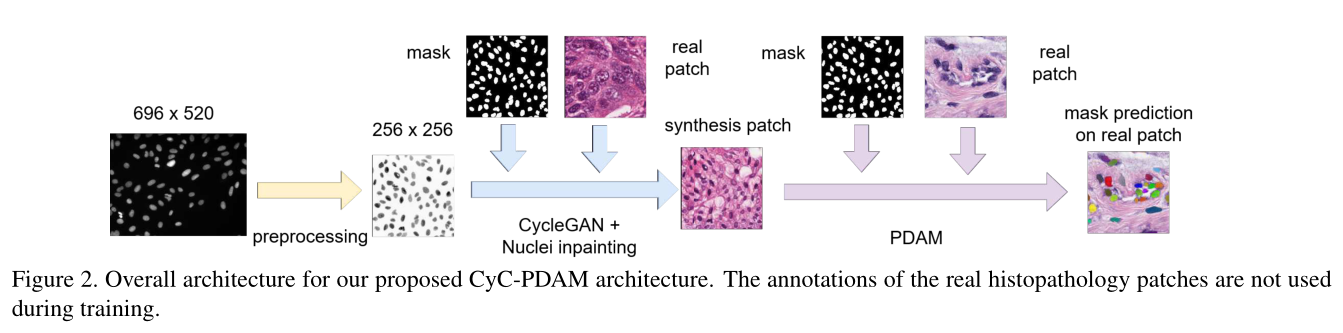

通过学习荧光显微镜图像,提出一种用于组织病理学图像的无监督核分割的Cycle Consistency Panoptic Domain Adaptive Mask R-CNN (CyC-PDAM)

将目标检测中的UDA方法直接用于实例分割任务主要存在两个问题:

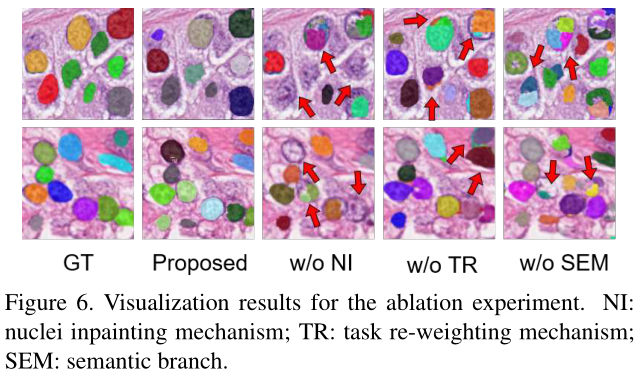

- 现有UDA方法侧重于减轻图像级(图像对比度、亮度等)和示例级别(对象比例、样式等)的域偏差。忽视了语义级别的域迁移(如前景和背景之间的关系以及对象的空间分布)。

- UDA目标检测方法是多任务学习,可同时优化不同的损失函数。如果没有学习到域不变特征,则损失函数将使得模型偏向源域。

本文贡献:

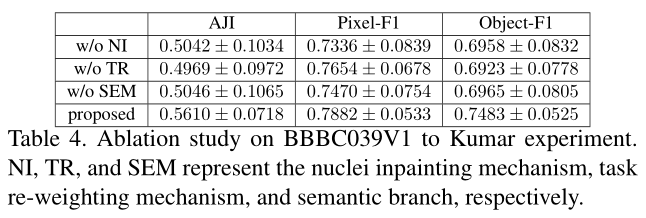

- 为组织病理学图像中的UDA核实例分割提出了CyC-PDAM模型。

- 提出了一个简单的原子核修复机制,以去除合成图像中的假阳性对象。

- CyC-PDAM通过融合实例级别适应模块和语义级别适应模块,生成了基于全景级别的域不变性特征。

- 提出了一种任务重新加权机制,减轻对源域的偏置。

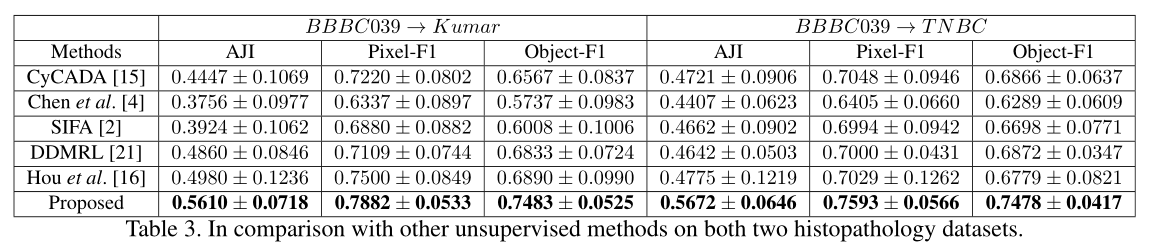

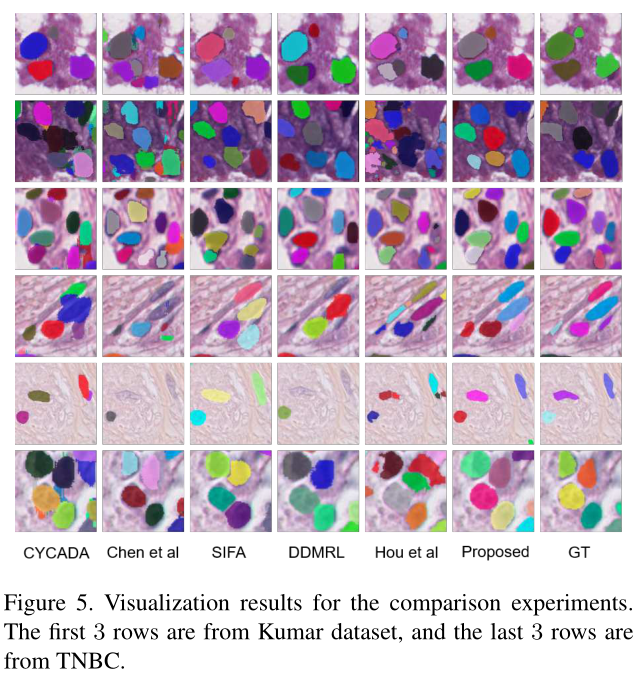

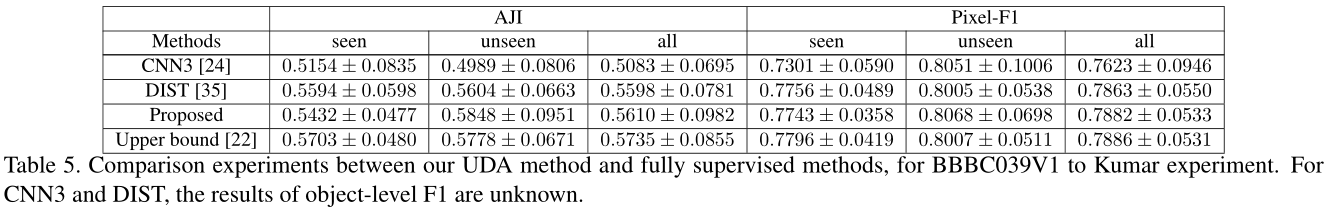

- 与最新的UDA方法相比,CyC-PDAM具有竞争优势。

Methods

提出的方法主要基于CyCADA,将CyCADA与Mask R-CNN相结合。

CyCADA with Mask R-CNN

目前没有用于实例分割的UDA模型,于是设计了域自适应的Mask-R-CNN。

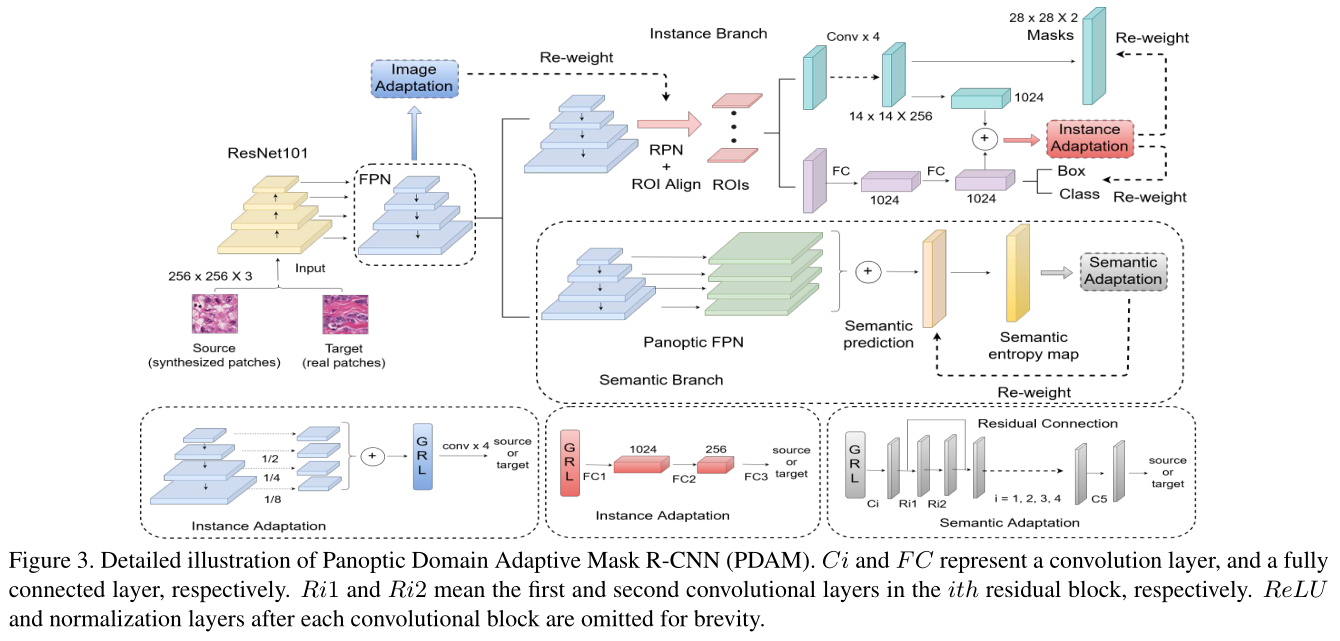

Backbone主要使用ResNet101和Feature Pyramid Network(FPN)。

在FPN后加入一个判别器用于图像级别自适应,实例分支后加入另一个判别器进行实例级别自适应。

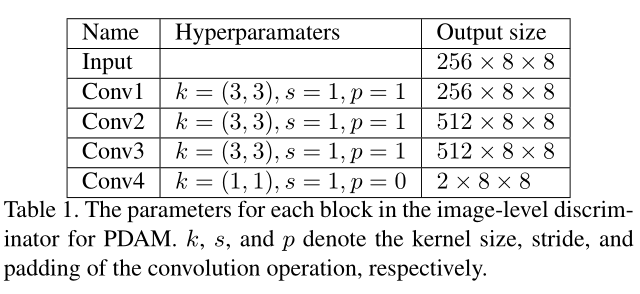

图像级判别器由4个卷积层和一个gradient reversal layer(GRL)组成,具体参数如下表。

实例级判别器由3个全连接层和一个GRL组成,输入为\(14 \times 14 \times 256\),平均池化降采样至\(2 \times 2 \times 256\),然后调整为\(1024 \times 1\),再与bounding box分支的\(1024 \times 1\)特征相加。

Nuclei Inpainting Mechanism

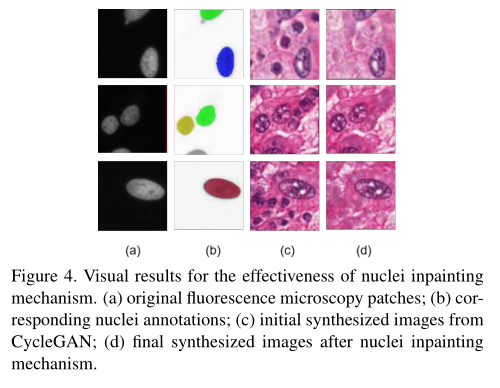

CycleGAN能够很有效的合成目标域图像,但生成图像的标签空间可能会发生变化。合成图像中可能存在多余的和不需要的原子核,这些将被视为背景类。

首先计算出辅助生成的核的Mask(\(M_{aux}\)):

\[M_{aux}=(otsu(S_{raw})\cup M)-M\]

其中,\(S_{raw}\)为初始生成的图像,\(M\)为对应的Mask,\(ostu(S_{raw})\)为使用Otsu二值化的结果。

去除多余的核,得到合成图像\(S_{inp}\)。

\[S_{inp}=inp(S_{raw},M_{aux})\]

将\(M_{aux}\)标记的多余的核替换为未标记的背景像素值,实现原子核修复的视觉效果。直接修复使得合成图像的文理和外观不太真实。但,image-level adaptation能够解决这个问题。

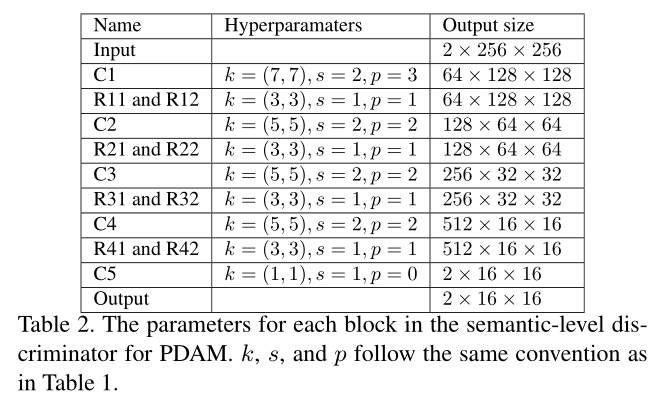

Panoptic Level Domain Adaptation

In addition to the image- and feature-level domain bias, the domain shift at the semantic level also exists.

在FPN的输出后加入语义分支,用于分割预测。

由于荧光显微镜图像和组织病理学图像均可以从组织样品中获取,并且它们可以显示互补和相关的信息,因此合成的和真实的组织病理学图像的这些语义分割标签空间具有很强的相似性。

Task Re-weighting Mechanism

提出了一种任务重新加权机制,以根据域鉴别符的预测为每个特定于任务的损失函数增加一个权衡权重。

设定最终预测任务的源域目标域的特征概率图分别为\(p_s\)和\(p_t\),特定任务的损失为\(L\),重新加权的损失为\(L_{rw}\)。

\[L_{r w}=\min \left(\frac{p_{t}}{p_{s}}, \beta\right) L=\min \left(\frac{1-p_{s}}{p_{s}}, \beta\right) L\]

如果源域趋向1,则减小损失,以减轻模型对源域的偏向。

网络结构中分别对RPN、语义分支、实例分支的损失进行加权。

Network Overview and Training Details

\[\begin{aligned} L_{\text {pdam}} &=\alpha_{\text {img}} L_{\text {rpn}}+\alpha_{\text {ins}} L_{\text {det}}+\alpha_{\text {sem}} L_{(\text {sem}-s e g)} \\ &+\alpha_{\text {da}}\left(L_{(\text {img}-d a)}+L_{(\text {sem}-d a)}+L_{(\text {ins}-d a)}\right) \end{aligned}\]

Experiments