Code: https://github.com/brain-research/self-attention-gan

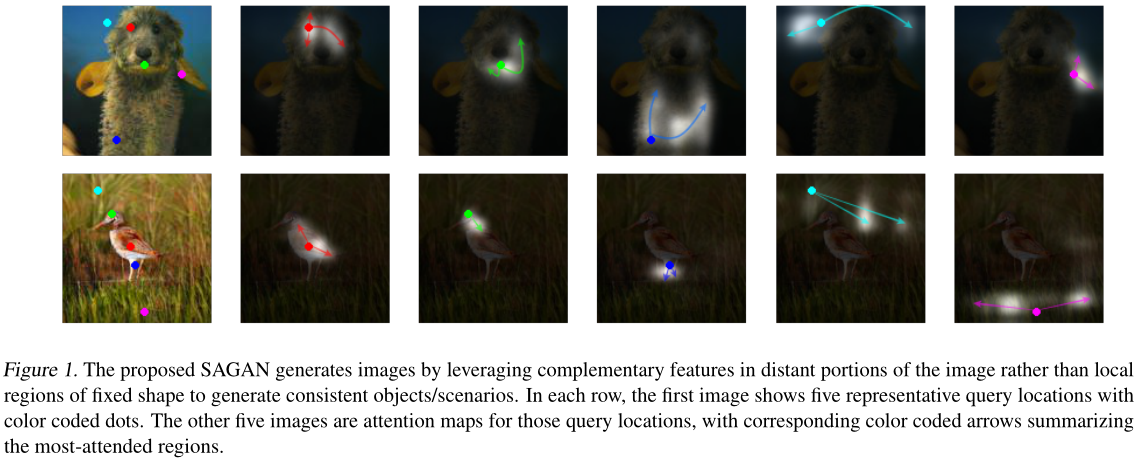

Motivation

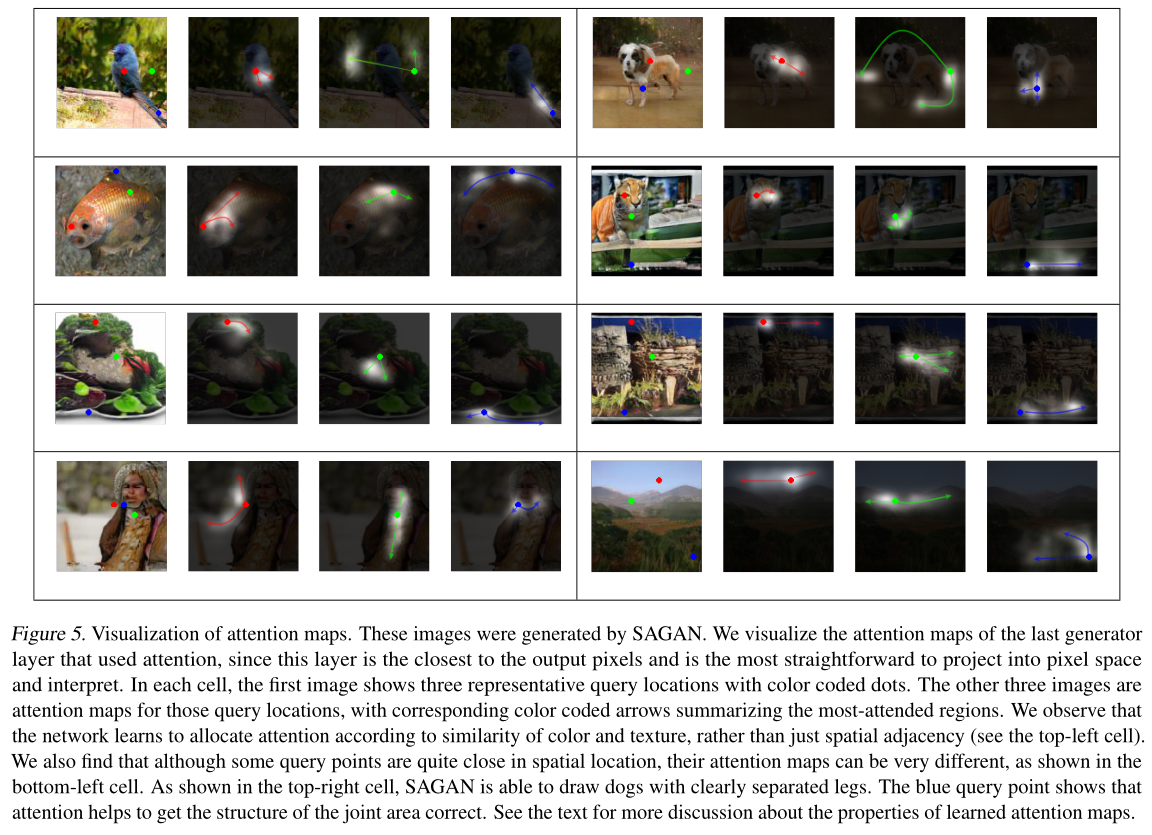

- 使用小的卷积核很难发现图像中的依赖关系

- 使用大的卷积核就丧失了卷积网络参数与计算的效率

Methods

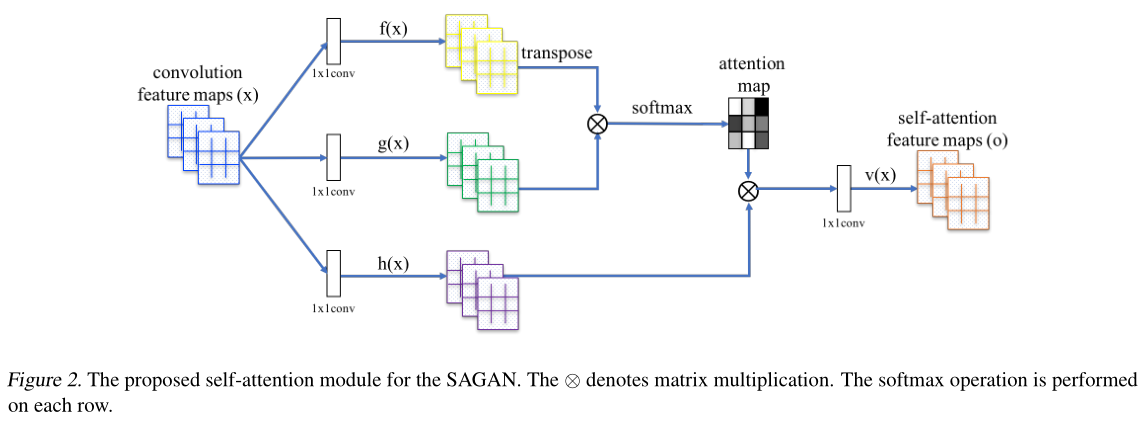

模型结构参照non-local model[1]

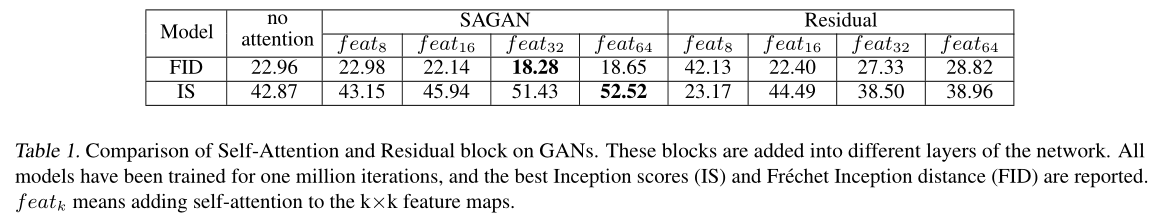

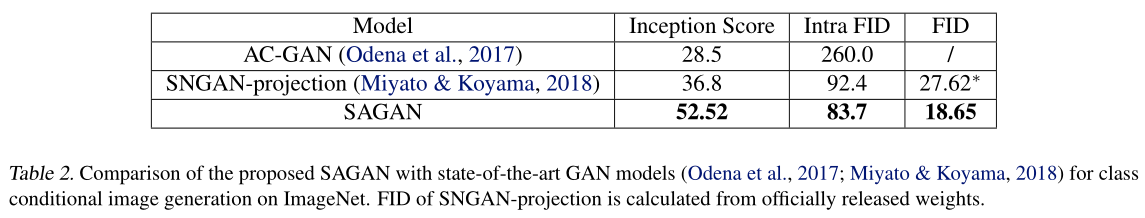

Experiments

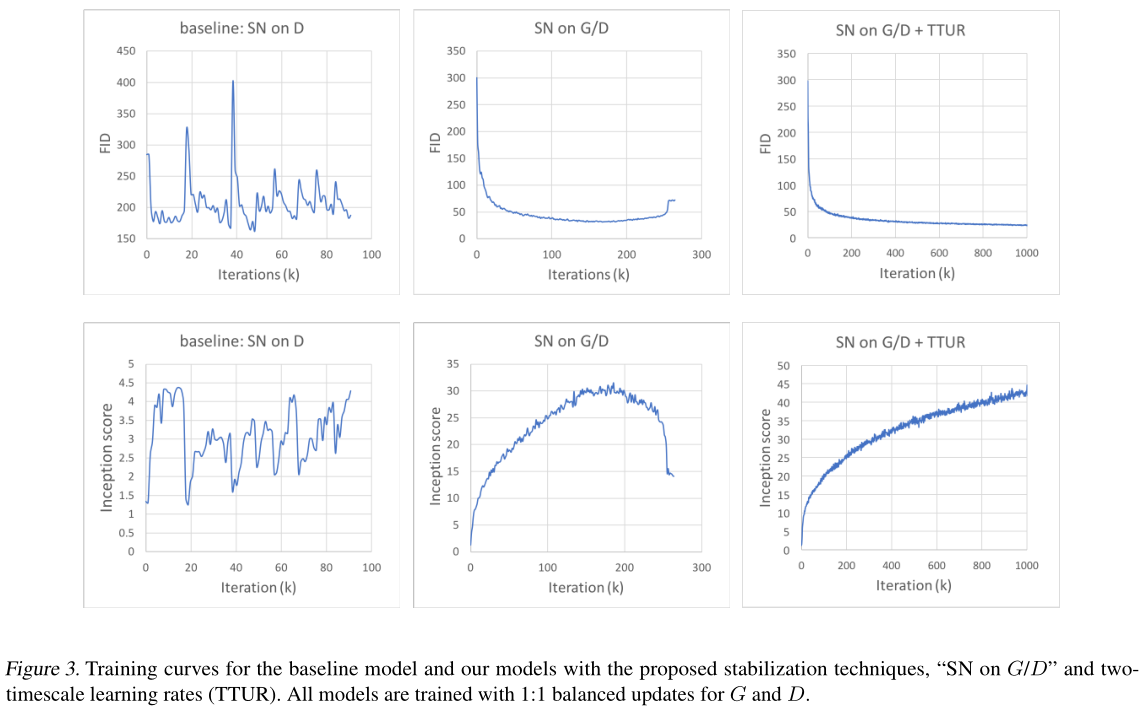

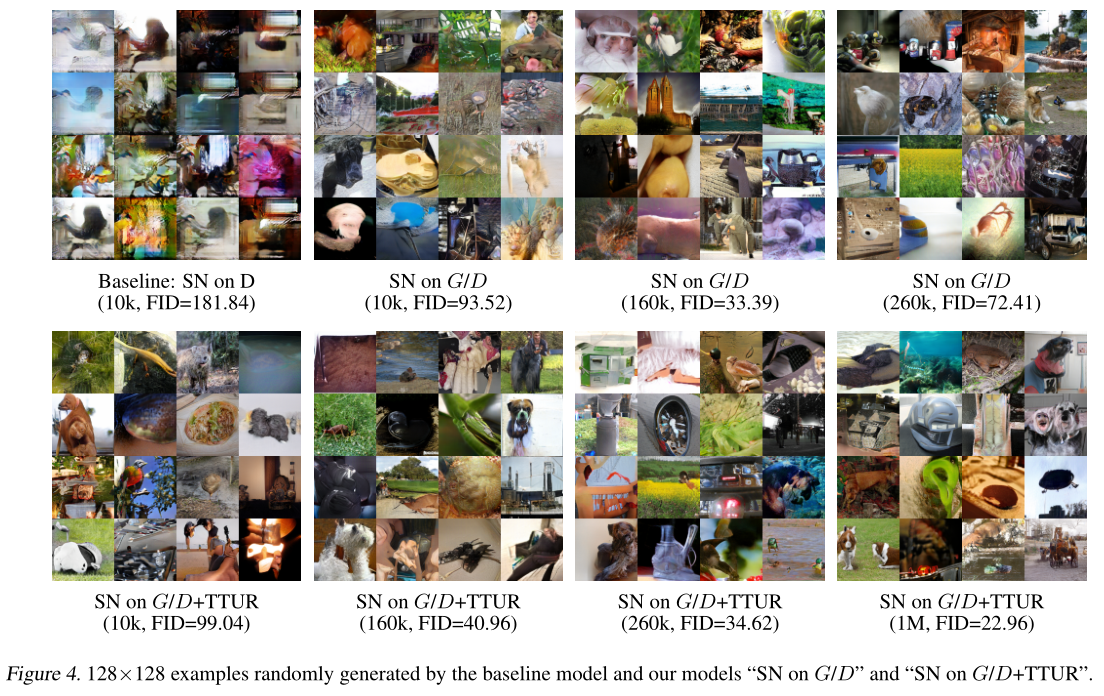

稳定训练过程的技巧

1、在生成器和判别器中均应用了Spectral normalization的方法:这个方法可以限制参数的分布(Lipschitz 条件),从而减少梯度爆炸等影响,稳定网络的训练。最初该方法只在判别器中使用,SAGAN中在生成器和判别器中均加入了Spectral normalization。 2、训练中使用Two Timescale Update Rule (TTUR):通常在GAN中G和D采用交替训练的方法,G训练一次后需要训练多次D(常见的是一次G,五次D),SAGAN使用了TTUR的方法,具体来说就是G和D使用不同的学习率(G为0.0001,D为0.0004),使得每一次生成器的训练之后判别器需要更少的训练次数。

参考文献

[1] Wang, X., Girshick, R., Gupta, A., and He, K. Non-local neural networks. In CVPR, 2018.